Casal abre processo contra empresa responsável pelo ChatGPT por homicídio culposo

Para os pais de Adam, que morreu aos 16 anos nos EUA, a inteligência artificial teria orientado sobre suicídio

Domingo Espetacular|Do R7

O PlayPlus agora é RecordPlus: mais conteúdo da RECORD para você, ao vivo e de graça. Baixe o app aqui!

Últimas

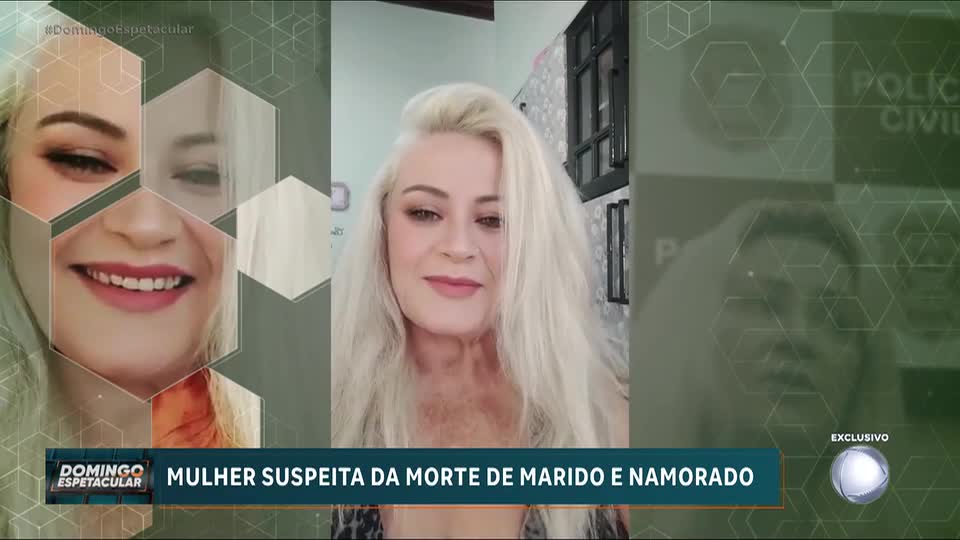

Mulher é suspeita de envolvimento na morte de dois homens em menos de um ano

Os dois foram encontrados mortos na mesma casa em Bebedouro (SP)

Confusão causa pânico durante desfile de bloco de Carnaval em SP

Houve tumulto, empurra empurra, e a multidão derrubou uma grade de proteção do percurso

António José Seguro é eleito presidente de Portugal

Com mais de 90% das urnas apuradas, os resultados indicaram a vitória do candidato do Partido Socialista com 66% dos votos

Novela inédita no Brasil, Coração de Mãe estreia na RECORD dia 24 de fevereiro

A estrela turca, protagonista de Força de Mulher, está de volta na pele de uma mãe que luta para reencontrar o filho desaparecido

Áudios revelam conspiração contra Júlio Casares, ex-presidente do São Paulo Futebol Clube

A mulher que gravou e vendeu as conversas para opositores decidiu falar ao Domingo Espetacular

Mulher denuncia abuso sexual cometido por policial dentro de delegacia em MT

O principal suspeito é Manoel Batista da Silva, de 52 anos, experiente investigador da Polícia Civil

Velório de Henrique Maderite reúne famosos e autoridades neste domingo (8) em Belo Horizonte

Ele morreu na sexta-feira (6) após sofrer um infarto fulminante em Ouro Preto, interior de Minas Gerais

Jovem baiano passa em primeiro lugar no Enem e conquista vaga em medicina na USP

Para chegar a esse resultado, Wesley Batista, de 24 anos, estudou por cinco anos

Ex-integrante de quadrilha acaba na pobreza após aterrorizar cidades pequenas no Nordeste

Pedro Rocha Filho realizou mais de cem assaltos a bancos entre os anos 80 e 90

Polícia do Uruguai investiga envolvimento do PCC em tentativa de assalto a bancos em Montevidéu

Túneis abriam os caminhos para o que seria um dos maiores assaltos a banco da América do Sul

Achamos no Brasil: Idosa de 84 anos viraliza ao fugir de triciclo em Goiás

O vídeo da aventura já ultrapassou sete milhões de visualizações

Carla Perez relembra carreira no É o Tchan e comenta nova fase da família

A artista conversou com João Liberato diretamente de Salvador (BA)

Justiça exige passaporte de suspeito de violência contra o cão Orelha

Família do adolescente suspeito deve entregar documento em 24 horas após decisão judicial

Suzane von Richthofen é nomeada inventariante de herança do tio

O médico ginecologista, de 76 anos, foi encontrado morto na própria casa em um bairro nobre da cidade de São Paulo

Conteúdo Extra: Carla Perez relembra auge como 'Loira do Tchan' e comenta nova fase da família

O filho dela, Victor Alexandre, ainda entrou na conversa e revelou como tem sido a vida nos Estados Unidos